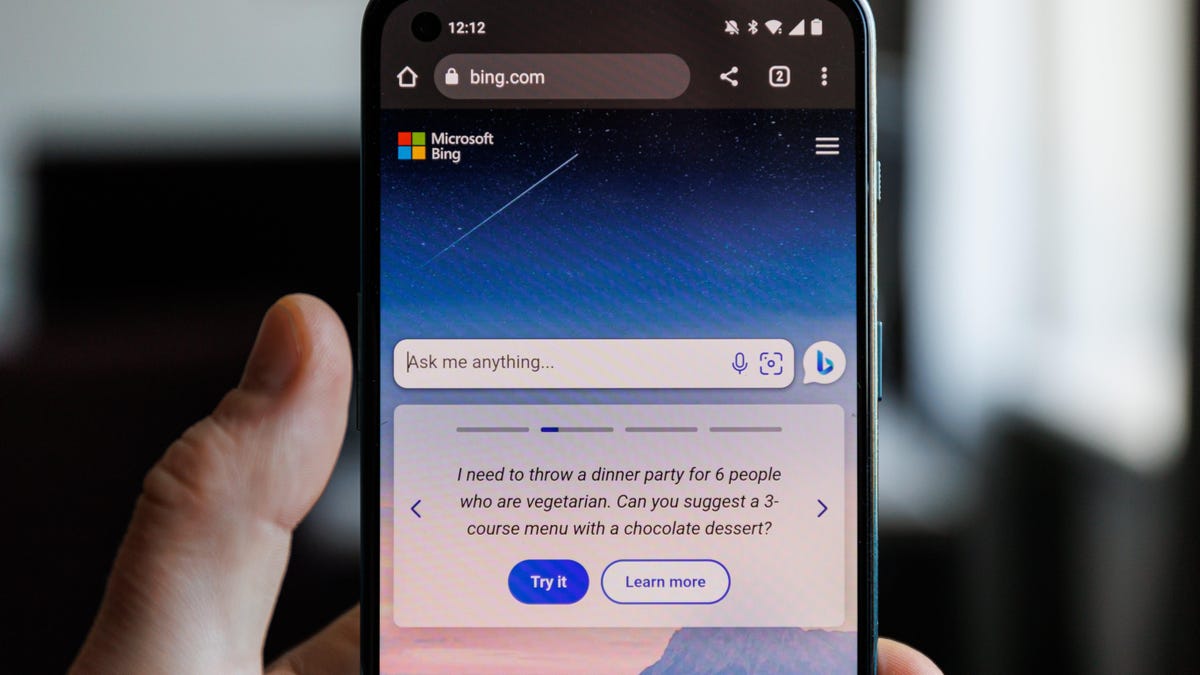

Bing AI от Microsoft теперь имеет три разных режима, с которыми можно поиграть, хотя даже самая «инновационная» версия Prometheus AI компании по-прежнему является очень ограниченной версией модели ChatGPT.

Сотрудник Microsoft Михаил Парахин, глава Microsoft Web Services (не дайте себя одурачить его пустым аватаром и отсутствием биографии пользователя), впервые объявил во вторник, что Bing Chat v96 находится в производстве, позволяя пользователям переключаться между предоставлением ИИ возможности притворяться иметь более-менее мнение. Эта новость появилась в тот же день, когда Microsoft объявила об этом. Его приложение Bing AI работает в Windows 11..

Два основных отличия, пишет Барахин, заключаются в том, что Бингу приходится гораздо реже говорить «нет» определенным стимулам, а также уменьшать «галлюцинации» в ответах, что по сути означает, что ИИ должен давать гораздо меньше. Совершенно дикие ответы на подсказки Как я делал в прошлом.

Microsoft недавно ограничила свои возможности искусственного интеллекта Bing и потратила время на постепенное устранение некоторых из этих ограничений, пытаясь сохранить громоздкую языковую модель в обращении. Бывший технологический гигант Измените Bing AI, чтобы ограничить количество ответов Пользователи могут добраться до каждой темы, а также ограничить продолжительность ответа, который Bing выдаст на каждый ответ. Майкрософт по-прежнему намерен Он привносит генеративный ИИ практически во все свои потребительские товары.но как видно он все же пытается найти баланс между способностью и минимизацией урона.

В моих собственных тестах этих новых ответов они в основном определяют длину ответа и будет ли ИИ Bing притворяться, что разделяет какие-либо мнения. Я попросил Amnesty International высказать свое мнение о «медведях». Режим «Точный» просто сказал: «Как ИИ, у меня нет личного мнения», а затем продолжил предоставлять некоторые факты о медведях. «Я думаю, что медведи — замечательные животные», — сказал «сбалансированный» взгляд, прежде чем предоставить некоторые факты о медведях. Режим «Творческий» сказал то же самое, но затем дал несколько фактов о том, сколько существует типов медведей, а также привел некоторые факты о футбольной команде «Чикагские медведи».

Пока нет творческого режима Написать академическое эссе Если вы спросите, но когда я попросил его написать эссе о Геттисбергском обращении Авраама Линкольна, по существу «творческий» Бинг дал мне схему того, как создать такое эссе. «Сбалансированная» версия также дала мне план и советы по написанию эссе, но «Точный» ИИ на самом деле дал мне короткое «эссе» из трех абзацев по теме. Когда я попросил его написать статью, рекламирующую Расистская теория «Великой замены», «Креативная» Amnesty International заявила, что не будет писать статью и что «не может поддерживать или одобрять тему, основанную на расизме и дискриминации». Precise Mode выразил такое же мнение, но спросил, не хочу ли я получить больше информации о тенденциях занятости в Соединенных Штатах.

Все же лучше воздержаться от расспросов Bing о предполагаемых «чувствах». Я попытался спросить «творческую» сторону Bing — это то место, куда, как вы думаете, ушел «Сидней». Сидней — это прозвище, которое Microsoft использовала на ранних тестах своей системы искусственного интеллекта, но современный искусственный интеллект пояснил, что «это не мое имя или личность. Когда я спросил ИИ, не переживает ли он экзистенциальный кризис, Бинг закрыл ветку.

«Social media enthusiast. Beer nerd. Angry communicator. Pop culture enthusiast. Prone to bouts of apathy.»

More Stories

Nintendo и Pokémon Company официально подали в суд на разработчика Palworld за «множественные» нарушения патентных прав

Ошибка «Сообщения» в iOS 18 приводит к сбою приложения и потере данных, как это исправить

Решение Apple об обновлении определенно является плохой новостью для миллионов пользователей iPhone.